Immagino sia plausibile che tu abbia sentito parlare dell’AI Act, il regolamento in discussione in UE per stabilire delle norme sull’Intelligenza Artificiale.

Dunque - detta come non la dovresti dire a un colloquio - l’AI Act è un regolamento di “product safety”, ossia mira a far sì che i prodotti di IA messi sul mercato siano sicuri. Come lo fa? Con un risk-based approach, esemplificato da questa piramide, pubblicata ad aprile 2021 (una vita fa!):

Il criterio è abbastanza semplice: invece di regolamentare le tecnologie in sè, l’UE ha stabilito 4 livelli di rischio, secondo i quali sono poi classificate le tecnologie di IA. Brando Benifei, europarlamentare co-rapporteur dell’AI Act, mi ha recentemente spiegato che “questo è il modo migliore per rendere l’AI Act a prova di futuro”.1

Ed ha effettivamente funzionato. A parte una piccola, ma enorme, eccezione: ChatGPT. Sì, non è uno scherzo: l’AI Act non aveva previsto non solo ChatGPT, ma tutti i sistemi simili.

Ma procediamo con calma. Dunque, non è proprio ChatGPT in sé a non essere stato previsto, ma GPT 3 o 4, ossia il foundation model (FM) che, come dice il nome, ne è alla base.

Pausa tecnica: per “foundation model” si intendono “dei modelli di machine learning addestrati su grandi quantità di dati che possono essere adattati a un'ampia gamma di compiti”.

In italiano: sistemi che hanno tantissimi dati e che sono dei tuttofare: possono scrivere una filastrocca per la mamma, correggerti i compiti di spagnolo, scrivere la lettera più cattiva che tu possa concepire, creare una fake news perfetta, programmare un virus, e molto altro.

Ecco, proprio questa pluralità di task che ChatGPT, grazie a GPT, o altri chatbot, grazie ad altri FMs, hanno creato non pochi problemi a Bruxelles.

Se, infatti, l’AI Act si basa sull’idea che ogni applicazione di IA possa essere assegnata a una categoria di rischio in base all'uso previsto, con i FMs diventa impossibile fare ciò perché non esiste UN uso previsto, ma ce ne sono tantissimi e di difficile predizione.

E quindi, ancor prima di vedere la luce, l’AI Act incontra una difficoltà non da poco. Che è sia tecnica che politica, perché coinvolge non solo gli esperti di regolamentazione, ma anche chi sviluppa foundation models e gli stati europei, tra cui l’Italia. Tutti, disperatamente, alla ricerca di regole perché l’AI Act possa essere approvato.

Di questa specifica questione dei FMs nell’AI Act, senza dilungarci, ne parla Artifacts.

Il Titolo

Diversamente dal solito, partiamo dalla questione politica, che si sta svolgendo proprio in queste ore prima dei triloghi sull’AI Act.

Semplificando, le posizioni vedono:

Parlamento UE, che vuole promuovere il cosiddetto ‘tiered approach’, ossia classificare i FMs secondo vari criteri - e su quali siano questi si sta giocando la questione - e assegnare quindi poi livelli di regolamentazione diversi;

Il Consiglio Europeo, ma soprattutto la cordata Germania - Francia - Italia, che invece vuole un approccio decisamente mooooolto di laissez-faire;

La Presidenza del Consiglio dell’UE (che non è quello di sopra), ossia la Spagna, che sta cercando di mediare per chiudere l’AI Act. Cosa decisamente prioritaria perché il rischio è che possa poi essere rimandato a dopo le elezioni del Parlamento a giugno ‘24.

Presto per dire come andrà a finire. Ad oggi, Euractiv riporta che sono in corso trattative per far sì che si trovi un compromesso.

Indubbiamente, è interessante fare luce sullo strappo di Germania - Francia - Italia, che non nasce certo dal nulla. Al centro ci sono gli interessi nazionali e delle start-up che provano a sgomitare perché, per una volta, l’UE non resti indietro sull’innovazione. Nello specifico, Mistral AI per la Francia e Aleph Alpha per la Germania. Per l’Italia, ahimè, è mero calcolo politico e al momento non ci sono grosse novità sul fronte innovazione.

In ogni caso, la loro volontà è decisamente eccessiva: il documento circolato nel weekend mirava a escludere una regolamentazione obbligatoria per i FMs e, invece, ad una non ben precisata “mandatory self-regulation”, che sembra, quantomeno, una contraddizione in termini. Ed altre critiche interessanti, di cui ha parlato Philippe Hacker. Addirittura, Yoshua Bengio, computer scientist canadese, ha detto a Politico che una soluzione simile sarebbe “folle” e porterebbe ad un AI Act simile alla “legge della giungla”.

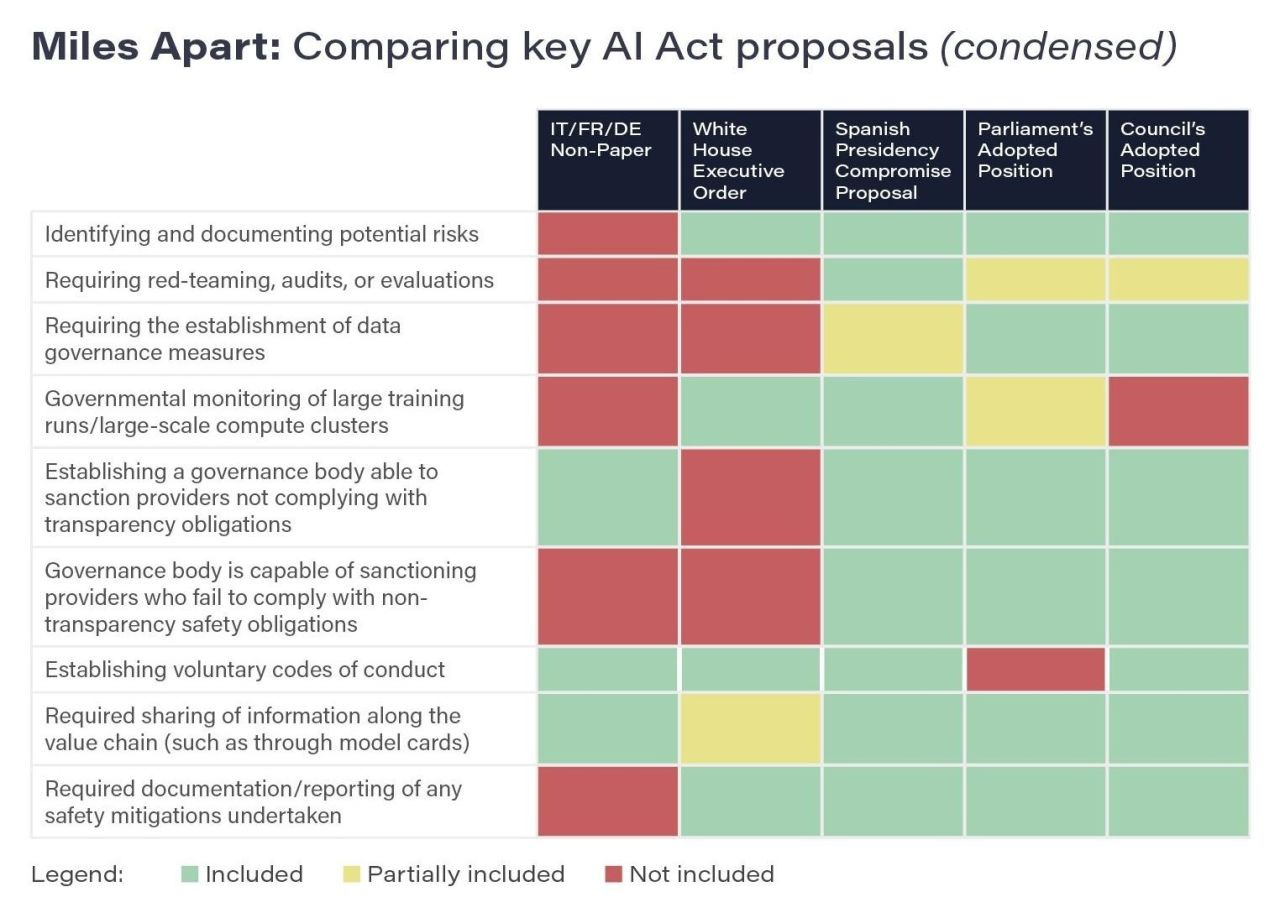

Come si evince dal grafico, il modello immaginato sarebbe carente su diversi aspetti, sostiene il Future of Life Institute. Al contrario, le altre soluzioni pensate in UE sembrano più ragionevoli in termini di efficacia.

Andando oltre le questioni politiche, comunque, la complessità di regolamentare i FMs è sui criteri da utilizzare, non tanto sul modello.

Che si debba adottare un “tiered approach”, ossia su più livelli, è ampiamente approvato, oltre che dalla Presidenza spagnola del Consiglio, anche dall’executive order di Biden o dalla community open-source. Più problematiche sorgono sui criteri che vanno utilizzati per creare questi livelli differenti.

Si tratta di una questione estremamente tecnica, che non è possibile approfondire su Artifacts, ma un elemento dovrebbe essere chiaro: serve partire dagli utilizzi di questi FMs. Che significa? Come suggerisce Rishi Bommassani, dello Stanford Centre for Research of Foundation Models, per l’UE la soluzione ideale sarebbe quella di provare a misurare l’impatto di questi modelli attraverso la loro diffusione. Semplificando, che chi sviluppa un sistema basato su un foundation model sia tenuto a registrarlo, e che quindi poi i modelli, e non i sistemi, siano classificati in questi diversi livelli di tiered approach di conseguenza. Insomma, alla domanda “quanto è rischioso GPT-4?” si dovrebbe rispondere valutando quanto sia vastamente utilizzato.

Approccio che ha dei meriti e che, per quanto comunque approssimativo, riflette un punto essenziale sui FMs: se non possiamo stabilirne i rischi a priori, possiamo provare a valutarne gli usi concreti.

Vedremo come andranno le cose in UE con l’AI Act: sono giornate calde.

Rassegna (Stampa)

In 5 giorni Sam Altman è stato: (1) licenziato da CEO di OpenAI, (2) assunto da Microsoft per un nuovo team su AI, (3) riassunto da OpenAI come CEO. Tralasciando la cronaca, un bel commento sulla vicenda.

Semplificato, come funziona un LLM:

L’UNESCO ci guida all’uso dell’IA Generativa per educazione e ricerca.

Il Garante Privacy apre una indagine sulla raccolta dei dati per il training di IA.

Lo Scaffale

Visto che qua finiamo sempre a parlare dell’UE, “Il codice del futuro” è un ottimo libro che spiega un po’ della storia, dell’ispirazione e dell’avvenire di come stiamo provando a regolamentare la tecnologia. Roberto Viola, tra l’altro, nientepopodimenoche Direttore Generale per le politiche digitali della Commissione europea.

Nerding

Immagina un ChatGPT per la musica. Vero, ne avevo suggerito uno simile, ma Suno fa dei pezzi veramente atomici e ti permette a tutti gli effetti di chattare con il tool di creazione della musica.

[Ci ho parlato per un altro progetto, non Artifacts, ma credo che riutilizzare le sue parole sia classificato come minimal risk :) ]